Key Takeaways

- Deep Learning (Học Sâu) là lĩnh vực con của Machine Learning, sử dụng Mạng Neural Nhân Tạo với nhiều lớp ẩn để tự động học và trích xuất đặc trưng từ dữ liệu lớn, mô phỏng bộ não con người.

- Nền tảng cốt lõi của Deep Learning là Mạng Neural Sâu (DNNs) gồm nhiều lớp neuron liên kết, xử lý thông tin qua trọng số, độ lệch và hàm kích hoạt, cho phép biểu diễn các mối quan hệ phức tạp.

- Quá trình huấn luyện Deep Learning bao gồm lan truyền thuận (tính toán đầu ra), tính toán hàm mất mát (đo lỗi) và lan truyền ngược (cập nhật trọng số, độ lệch) để tối thiểu hóa lỗi dự đoán.

- Các kiến trúc mạng neural sâu phổ biến bao gồm CNN (cho hình ảnh), RNN/LSTM (cho dữ liệu chuỗi) và Transformer (cho dữ liệu chuỗi, NLP) được phát triển cho các loại bài toán và dữ liệu khác nhau.

- Deep Learning đã tạo ra nhiều ứng dụng đột phá trong Thị giác máy tính, Xử lý ngôn ngữ tự nhiên, nhận dạng giọng nói, hệ thống khuyến nghị, y tế, tài chính và nhiều lĩnh vực khác.

Trong kỷ nguyên số hóa, trí tuệ nhân tạo (AI) đang len lỏi vào mọi khía cạnh của cuộc sống. Giữa vô vàn khái niệm AI, Deep Learning là gì nổi lên như một thế lực mạnh mẽ, thúc đẩy những đột phá ấn tượng nhất. Nó không chỉ là một từ khóa công nghệ thời thượng, mà còn là nền tảng cốt lõi cho nhiều ứng dụng thông minh mà chúng ta sử dụng hàng ngày. Bài viết này sẽ đi sâu giải đáp câu hỏi “Deep Learning là gì?“, khám phá cơ chế hoạt động thông qua Mạng Neural Sâu (Deep Neural Networks) và những ứng dụng thực tiễn đã và đang thay đổi thế giới.

Deep Learning Là Gì?

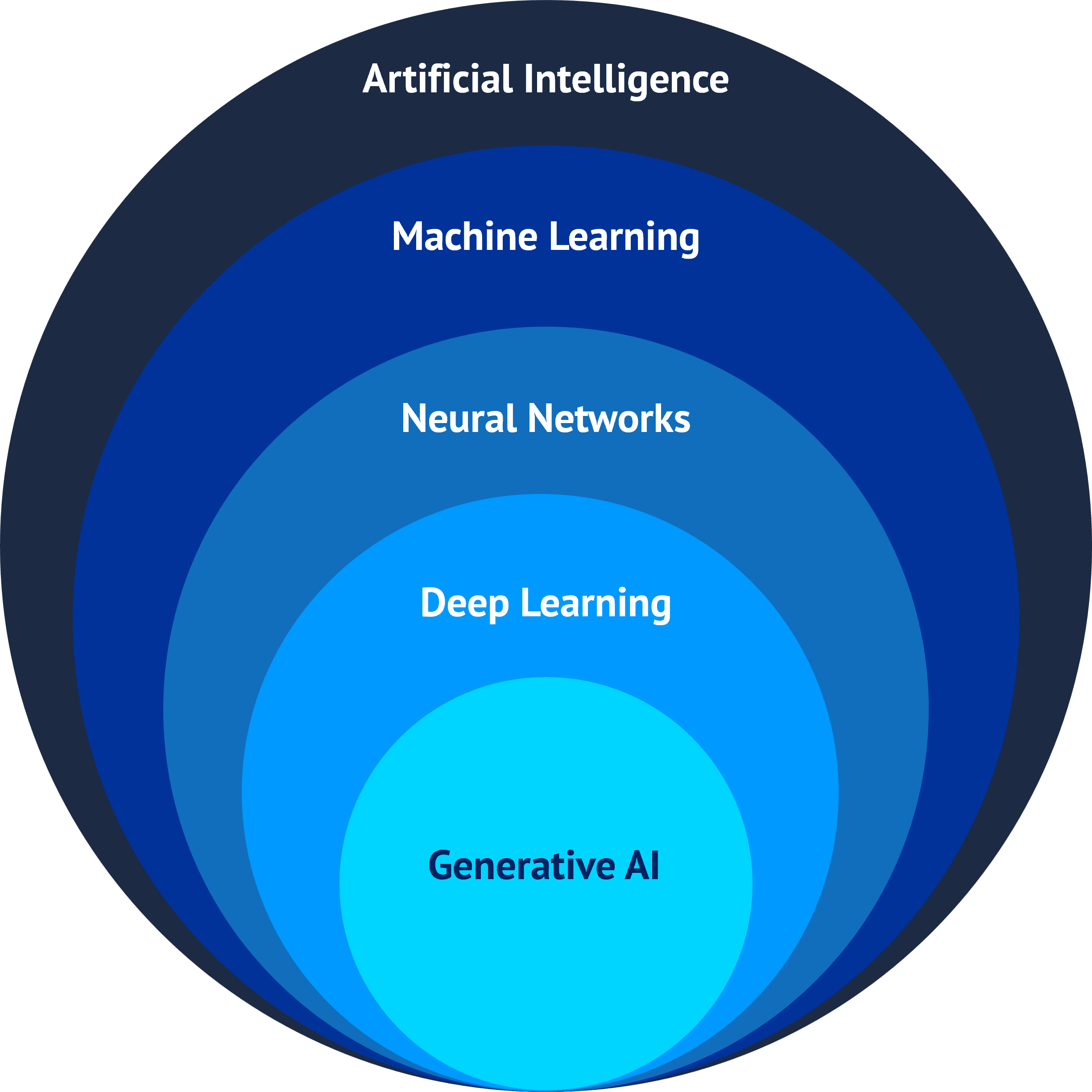

Deep Learning (Học Sâu) là một lĩnh vực con của Machine Learning (Học Máy), bản thân nó lại là một nhánh của Trí Tuệ Nhân Tạo. Khái niệm Deep Learning dựa trên việc xây dựng và huấn luyện các Mạng Neural Nhân Tạo (Artificial Neural Networks – ANN) với nhiều lớp ẩn (hidden layers) để mô phỏng cách bộ não con người xử lý thông tin và học hỏi từ một lượng lớn dữ liệu. Chính số lượng lớn các lớp này tạo nên độ “sâu” (deep) của mạng.

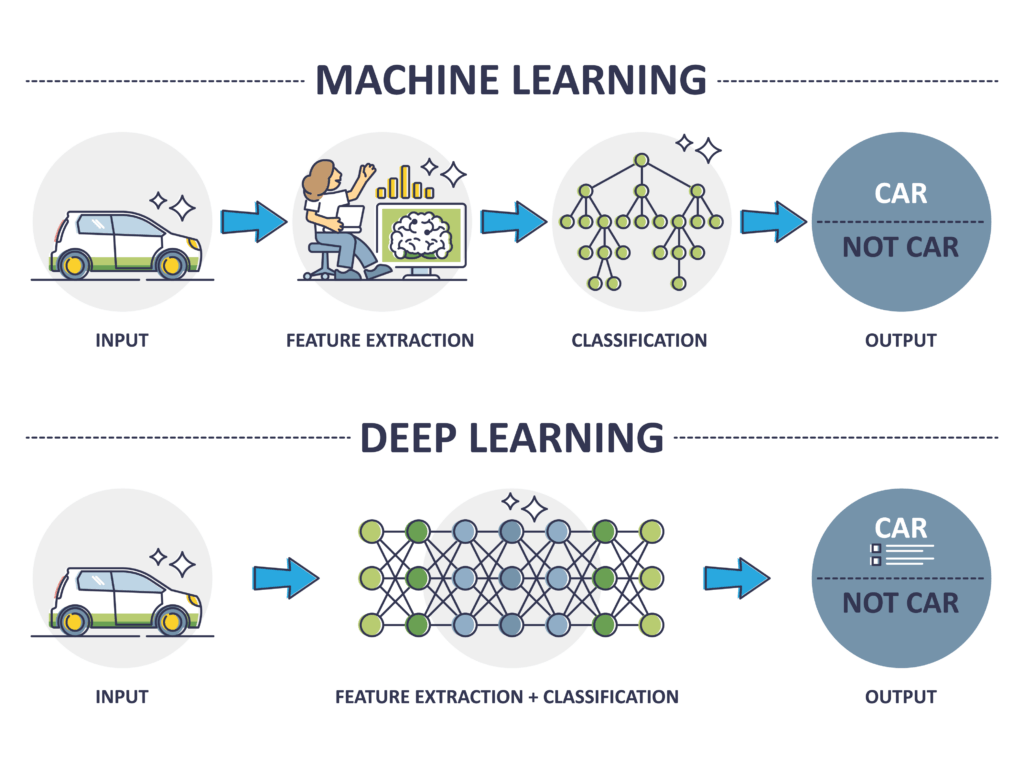

Điểm khác biệt cốt lõi giữa Deep Learning và Machine Learning (Học Máy) truyền thống nằm ở khả năng trích xuất đặc trưng. Các thuật toán Machine Learning cổ điển thường yêu cầu chuyên gia phải lựa chọn và tiền xử lý đặc trưng (features) từ dữ liệu đầu vào một cách thủ công. Ngược lại, mô hình Deep Learning có khả năng tự động học và phân cấp các đặc trưng trực tiếp từ dữ liệu thô, từ những đặc trưng đơn giản ở lớp đầu tiên đến các đặc trưng phức tạp hơn ở các lớp sâu hơn.

Khả năng tự động học đặc trưng này giúp Deep Learning cực kỳ hiệu quả khi xử lý dữ liệu phi cấu trúc phức tạp như hình ảnh, video, âm thanh và văn bản. Nó cho phép máy tính nhận diện các mẫu tinh vi mà con người khó có thể xác định thủ công. Vì vậy, hiểu rõ Deep Learning là gì chính là nắm bắt chìa khóa của nhiều công nghệ AI tiên tiến.

Nền Tảng Của Deep Learning: Mạng Neural Sâu (Deep Neural Networks)

Trái tim của Deep Learning chính là Mạng Neural Sâu (Deep Neural Networks – DNNs), thường được gọi tắt là Neural Networks khi nói về học sâu. Cấu trúc của một DNN bao gồm nhiều lớp tế bào thần kinh nhân tạo (neuron) được liên kết với nhau. Về cơ bản, một mạng neural có ba loại lớp chính: Lớp đầu vào (Input Layer), một hoặc nhiều Lớp ẩn (Hidden Layers), và Lớp đầu ra (Output Layer).

Mỗi neuron trong mạng nhận tín hiệu đầu vào từ các neuron ở lớp trước đó (hoặc từ dữ liệu gốc đối với lớp đầu vào). Các tín hiệu này được nhân với các trọng số (weights) tương ứng – đại diện cho độ mạnh của kết nối. Tổng các tín hiệu có trọng số này sau đó được cộng thêm một giá trị độ lệch (bias) và đưa qua một hàm kích hoạt (activation function).

Hàm kích hoạt đóng vai trò quyết định xem neuron có nên được “kích hoạt” hay không và tín hiệu đầu ra của nó sẽ là gì. Các hàm kích hoạt phi tuyến phổ biến như ReLU, Sigmoid, Tanh giúp mạng neural học được các mối quan hệ phức tạp và phi tuyến trong dữ liệu. Chính sự kết hợp của cấu trúc đa tầng, trọng số, độ lệch và hàm kích hoạt tạo nên sức mạnh biểu diễn của Neural Networks sâu.

Cơ Chế Hoạt Động và Quy Trình Huấn Luyện

Quy trình hoạt động và huấn luyện một mô hình Deep Learning diễn ra qua các bước lặp đi lặp lại. Đầu tiên là quá trình lan truyền thuận (forward propagation). Dữ liệu đầu vào được đưa qua mạng, từ lớp đầu vào, qua các lớp ẩn, đến lớp đầu ra để tạo ra một dự đoán hoặc phân loại.

Tiếp theo, dự đoán của mô hình được so sánh với giá trị thực tế (nhãn) thông qua một hàm mất mát (loss function). Hàm này đo lường mức độ sai lệch giữa dự đoán và kết quả mong muốn. Mục tiêu của quá trình huấn luyện là tối thiểu hóa giá trị của hàm mất mát này, làm cho dự đoán của mô hình ngày càng chính xác hơn.

Để giảm thiểu lỗi, thuật toán lan truyền ngược (backpropagation) được sử dụng. Thuật toán này tính toán gradient (đạo hàm) của hàm mất mát theo từng trọng số và độ lệch trong mạng. Sau đó, các thuật toán tối ưu hóa (optimizers) như Gradient Descent hoặc Adam sử dụng các gradient này để cập nhật các trọng số và độ lệch theo hướng làm giảm lỗi. Quá trình lan truyền thuận, tính toán lỗi và lan truyền ngược được lặp lại nhiều lần (epochs) trên tập dữ liệu huấn luyện cho đến khi mô hình đạt được hiệu suất mong muốn.

Các Kiến Trúc Mạng Neural Sâu Phổ Biến

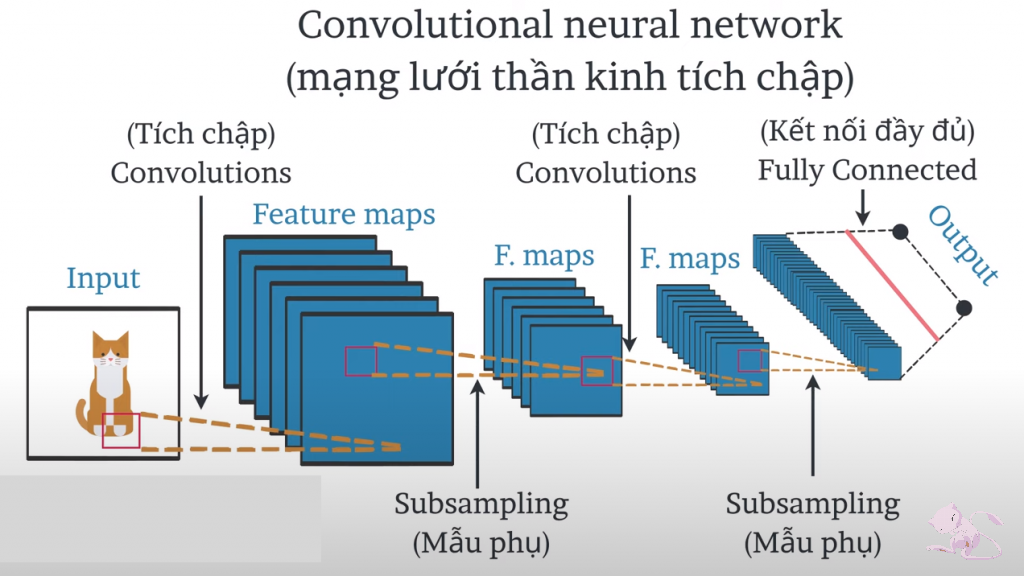

Tùy thuộc vào loại dữ liệu và bài toán cụ thể, các kiến trúc Neural Networks khác nhau đã được phát triển. Mạng Nơ-ron Tích chập (Convolutional Neural Networks – CNN) là kiến trúc tiêu chuẩn cho các bài toán xử lý hình ảnh và thị giác máy tính. CNN sử dụng các bộ lọc (kernels) để tự động học các đặc trưng phân cấp từ ảnh, như cạnh, góc, kết cấu, và các đối tượng phức tạp hơn.

Đối với dữ liệu dạng chuỗi hoặc tuần tự theo thời gian như văn bản, giọng nói, hoặc chuỗi thời gian, Mạng Nơ-ron Hồi quy (Recurrent Neural Networks – RNN) và biến thể mạnh mẽ hơn của nó là Long Short-Term Memory (LSTM) thường được sử dụng. Chúng có khả năng ghi nhớ thông tin từ các bước thời gian trước đó để đưa ra dự đoán cho bước hiện tại. Điều này rất quan trọng để hiểu ngữ cảnh trong ngôn ngữ tự nhiên hoặc dự báo xu hướng.

Gần đây, kiến trúc Transformer đã tạo ra một cuộc cách mạng trong lĩnh vực Xử lý Ngôn ngữ Tự nhiên (NLP) và ngày càng được ứng dụng rộng rãi cho các loại dữ liệu chuỗi khác, thậm chí cả hình ảnh. Transformer sử dụng cơ chế chú ý (attention mechanism) để tập trung vào các phần quan trọng nhất của dữ liệu đầu vào, cho phép xử lý hiệu quả các phụ thuộc xa trong chuỗi mà không bị giới hạn bởi bộ nhớ như RNN/LSTM.

Ứng Dụng Thực Tế Đột Phá của Deep Learning

Sức mạnh của khái niệm Deep Learning đã tạo ra vô số ứng dụng đột phá trong thực tế. Trong lĩnh vực Thị giác máy tính (Computer Vision), Deep Learning được dùng để nhận dạng đối tượng, phân loại ảnh, nhận diện khuôn mặt, phân tích video và trong các hệ thống xe tự hành để hiểu môi trường xung quanh.

Xử lý ngôn ngữ tự nhiên (NLP) là một lĩnh vực khác chứng kiến sự bùng nổ nhờ Deep Learning. Các ứng dụng bao gồm dịch máy tự động, phân tích tình cảm, tạo văn bản, chatbot thông minh, và tóm tắt văn bản. Các mô hình ngôn ngữ lớn như GPT-3, BERT là minh chứng rõ ràng cho tiềm năng này.

Nhận dạng giọng nói và âm thanh cũng đạt được độ chính xác cao nhờ Deep Learning, làm nền tảng cho các trợ lý ảo như Siri, Alexa, Google Assistant và các hệ thống chuyển đổi giọng nói thành văn bản. Các hệ thống khuyến nghị (recommendation systems) trên Netflix, Spotify, Amazon sử dụng Deep Learning để phân tích hành vi người dùng và đề xuất nội dung phù hợp.

Ngoài ra, Deep Learning còn đóng vai trò quan trọng trong Robotics, giúp robot nhận thức môi trường và tương tác linh hoạt hơn. Nó cũng được ứng dụng trong y tế để chẩn đoán bệnh qua hình ảnh y khoa, khám phá thuốc mới, và trong tài chính để dự báo thị trường, phát hiện gian lận. Việc hiểu Deep Learning là gì mở ra cánh cửa đến những công nghệ tiên tiến này.

Thách Thức Hiện Tại và Tiềm Năng Tương Lai

Mặc dù đạt được nhiều thành tựu, Deep Learning vẫn đối mặt với một số thách thức. Một trong những yêu cầu lớn nhất là lượng dữ liệu khổng lồ để huấn luyện hiệu quả. Việc thu thập và gán nhãn dữ liệu chất lượng cao tốn kém thời gian và công sức. Bên cạnh đó, các mô hình Deep Learning đòi hỏi tài nguyên tính toán mạnh mẽ, đặc biệt là các GPU hiệu năng cao, để xử lý các phép toán phức tạp.

Một vấn đề khác là tính giải thích (interpretability) hay còn gọi là vấn đề “hộp đen”. Các mô hình Deep Learning thường rất phức tạp, khiến việc hiểu tại sao chúng lại đưa ra một quyết định cụ thể trở nên khó khăn. Điều này có thể là rào cản trong các lĩnh vực yêu cầu độ tin cậy và minh bạch cao như y tế hay tài chính.

Tuy nhiên, lĩnh vực này đang phát triển không ngừng. Các nhà nghiên cứu đang tìm cách giải quyết những thách thức trên thông qua các kỹ thuật mới như Self-supervised Learning (Học tự giám sát – giảm phụ thuộc vào dữ liệu gán nhãn), Federated Learning (Học liên kết – huấn luyện mô hình trên nhiều thiết bị mà không cần chia sẻ dữ liệu gốc), và các phương pháp tăng cường tính giải thích. Tiềm năng tương lai của Deep Learning vẫn vô cùng rộng lớn.

Kết Luận

Qua bài viết này, chúng ta đã cùng nhau khám phá Deep Learning là gì, từ những khái niệm cơ bản về Mạng Neural Sâu (Neural Networks) đến cơ chế hoạt động và các ứng dụng thực tiễn đầy ấn tượng. Deep Learning không còn là một khái niệm xa vời mà đã trở thành động lực chính thúc đẩy cuộc cách mạng Trí Tuệ Nhân Tạo, mang lại những thay đổi sâu sắc trong cách chúng ta sống, làm việc và tương tác với công nghệ. Dù còn đối mặt với những thách thức, tiềm năng phát triển và ứng dụng của nó trong tương lai là không thể phủ nhận.

Việc hiểu rõ bản chất và sức mạnh của Deep Learning là gì giúp chúng ta không chỉ bắt kịp xu hướng công nghệ mà còn mở ra những cơ hội mới trong nghiên cứu và ứng dụng. Hy vọng bài viết đã cung cấp cái nhìn tổng quan và hữu ích về lĩnh vực đầy tiềm năng này. Hãy tiếp tục tìm hiểu và khám phá thế giới hấp dẫn của Trí tuệ nhân tạo và Deep Learning để đón đầu những thay đổi sắp tới!