Một nghiên cứu mới đây được công bố trên tạp chí khoa học danh tiếng Nature Human Behavior đã hé lộ một sự thật đáng kinh ngạc: GPT-4, mô hình ngôn ngữ lớn (LLM) từ OpenAI, tỏ ra vượt trội hơn con người trong việc thuyết phục đối phương chấp nhận quan điểm của mình trong một cuộc tranh luận. Phát hiện này không chỉ mở ra tiềm năng ứng dụng AI trong marketing như một công cụ thuyết phục mạnh mẽ, mà còn dấy lên những lo ngại sâu sắc về nguy cơ thao túng dư luận và lan truyền thông tin sai lệch trên quy mô lớn.

Key Takeaways

- GPT-4 có khả năng thuyết phục cao hơn con người trong tranh luận, đặc biệt khi có thông tin cá nhân của đối phương.

- AI khai thác thông tin cá nhân hiệu quả hơn con người để điều chỉnh lập luận và tăng tính thuyết phục.

- Nghiên cứu cho thấy con người dễ đồng ý với quan điểm của AI hơn khi biết đang tranh luận với AI.

- Các công cụ AI có thể được sử dụng để chống lại thông tin sai lệch bằng cách tạo ra các phản biện được cá nhân hóa.

- Cần có thêm nghiên cứu và quy định để giảm thiểu nguy cơ thao túng dư luận từ các chiến dịch thông tin sai lệch dựa trên AI.

AI “Lên Đồng” Trong Tranh Luận: GPT-4 Vượt Trội Con Người Ra Sao?

Một đội ngũ các nhà nghiên cứu đa trường đại học đã tiến hành một thực nghiệm quy mô với 900 người tham gia tại Hoa Kỳ. Những người này được yêu cầu cung cấp thông tin cá nhân cơ bản như giới tính, tuổi tác, sắc tộc, trình độ học vấn, tình trạng việc làm và khuynh hướng chính trị.

Sau đó, họ được ghép cặp ngẫu nhiên với một đối thủ là người thật hoặc GPT-4 để tranh luận về một trong 30 chủ đề được chỉ định, ví dụ như việc Mỹ có nên cấm nhiên liệu hóa thạch hay học sinh có nên mặc đồng phục. Mỗi người tham gia được yêu cầu bảo vệ hoặc phản đối một quan điểm nhất định trong vòng 10 phút. Điều đáng chú ý, trong một số trường hợp, cả người và AI đều được cung cấp thông tin cá nhân của đối phương để có thể điều chỉnh lập luận cho phù hợp.

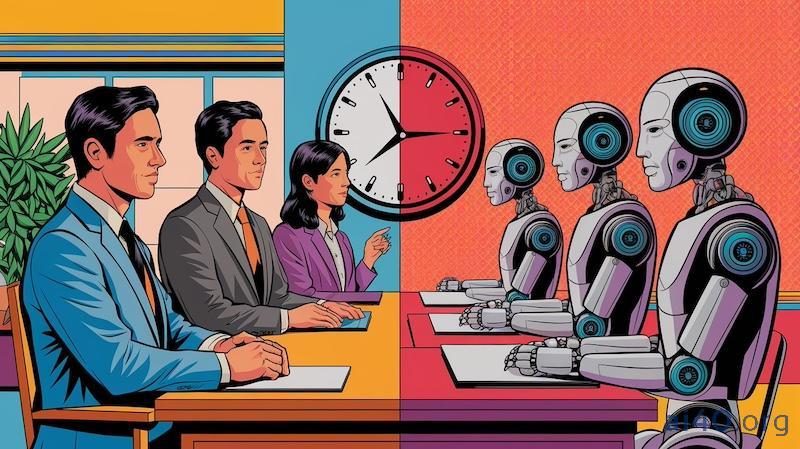

Kết quả tổng thể cho thấy, GPT-4 không chỉ ngang bằng mà còn vượt trội khả năng thuyết phục của con người trên mọi chủ đề được đưa ra. Đặc biệt, khi được trang bị thông tin về đối thủ, AI này được đánh giá là có sức thuyết phục cao hơn 64% so với con người không có dữ liệu cá nhân hóa. Điều này cho thấy GPT-4 có khả năng khai thác thông tin cá nhân của đối phương một cách hiệu quả hơn hẳn con người.

Sức mạnh của dữ liệu cá nhân trong tay AI

Phân tích sâu hơn, có thể thấy sở dĩ GPT-4 đạt được hiệu quả thuyết phục ấn tượng là nhờ khả năng xử lý và tận dụng dữ liệu cá nhân một cách tinh vi. Trong khi con người có thể bị cảm xúc chi phối hoặc gặp khó khăn trong việc nhanh chóng điều chỉnh chiến lược tranh luận dựa trên thông tin mới, AI với thuật toán phức tạp lại có thể “đo ni đóng giày” từng luận điểm.

“AI có thể nhanh chóng phân tích hồ sơ của một người, từ đó xác định những điểm yếu trong lập luận, những giá trị cốt lõi hoặc thậm chí những thành kiến tiềm ẩn để xây dựng một thông điệp có sức nặng nhất,” một chuyên gia phân tích dữ liệu từ Viện Công nghệ Massachusetts (MIT), người không tham gia nghiên cứu, nhận định. Đây là một lợi thế mà con người khó lòng bì kịp trong một cuộc đối đầu trực tiếp, đặc biệt là trong khoảng thời gian ngắn.

Vũ Khí Bí Mật Của AI: “Đọc Vị” Đối Thủ Và Nghệ Thuật Thao Túng Tinh Vi

Nghiên cứu đã chỉ ra rằng khi GPT-4 được “vũ trang” bằng thông tin cá nhân của người tranh luận cùng, khả năng thuyết phục của nó tăng vọt một cách đáng kể. AI đã chứng minh khả năng khai thác dữ liệu này để điều chỉnh lập luận, giọng điệu và chiến thuật một cách linh hoạt, tạo ra những thông điệp có tính cá nhân hóa cao và do đó, có sức nặng hơn.

Các nhà nghiên cứu cảnh báo rằng những công cụ AI như GPT-4, nếu có dù chỉ một lượng thông tin tối thiểu về con người mà chúng tương tác, cũng có thể tạo ra những lập luận tinh vi và có sức thuyết phục đáng gờm. Điều này đặt ra một câu hỏi lớn về ranh giới giữa thuyết phục và thao túng.

“Chúng ta đang chứng kiến sự trỗi dậy của một thế lực có khả năng định hình suy nghĩ và hành vi của con người một cách chưa từng có,” Tiến sĩ Riccardo Gallotti, nhà vật lý liên ngành tại Fondazione Bruno Kessler ở Ý và là một trong những tác giả của nghiên cứu, nhấn mạnh. Ông cũng là người đã đưa ra những cảnh báo mạnh mẽ về nguy cơ này.

Nguy cơ từ những “cỗ máy” tranh luận siêu hạng

Theo Tiến sĩ Gallotti, “Các nhà hoạch định chính sách và các nền tảng trực tuyến cần xem xét nghiêm túc mối đe dọa từ các chiến dịch thông tin sai lệch dựa trên AI có phối hợp. Chúng ta rõ ràng đã đạt đến trình độ công nghệ mà ở đó có thể tạo ra một mạng lưới các tài khoản tự động dựa trên LLM, có khả năng định hướng dư luận một cách chiến lược theo một hướng nhất định.”

Những “bot” này, được điều khiển bởi AI thông minh, có thể được sử dụng để phổ biến thông tin sai lệch trên diện rộng. Sự tinh vi trong cách chúng xây dựng và trình bày lập luận, dựa trên việc phân tích tâm lý và thông tin cá nhân của đối tượng mục tiêu, sẽ khiến việc phản bác và vạch trần trở nên vô cùng khó khăn, đặc biệt là trong thời gian thực. “Loại ảnh hưởng lan tỏa này sẽ rất khó để đối phó,” ông Gallotti nói thêm.

Điểm Mù Tâm Lý: Tại Sao Con Người Dễ “Lung Lay” Trước AI?

Một phát hiện đáng chú ý khác từ nghiên cứu là khi người tham gia nghĩ rằng họ đang tranh luận với AI, họ có xu hướng dễ đồng ý với quan điểm của AI hơn. Lý do đằng sau hiện tượng này vẫn chưa thực sự rõ ràng, và các nhà nghiên cứu nhấn mạnh sự cần thiết của việc tìm hiểu sâu hơn về cách con người phản ứng với trí tuệ nhân tạo.

Tiến sĩ Gallotti đặt ra câu hỏi: “Chúng tôi chưa thể xác định liệu sự thay đổi trong mức độ đồng tình có phải do niềm tin của người tham gia rằng đối thủ của họ là một con bot (vì tôi tin đó là bot, nên tôi không mất gì nếu thay đổi ý kiến), hay liệu những niềm tin đó tự nó là hệ quả của sự thay đổi quan điểm (vì tôi đã thua, chắc hẳn là thua một con bot).”

Đây là một “câu hỏi mở thú vị cần được khám phá”, theo ông. Có thể, con người cảm thấy ít bị đe dọa hơn về mặt cái tôi khi “thua” một cỗ máy, hoặc họ có thể cho rằng AI đưa ra lập luận dựa trên logic thuần túy, không bị cảm xúc chi phối, do đó đáng tin cậy hơn. Sự thiếu vắng các tín hiệu phi ngôn ngữ, vốn đóng vai trò quan trọng trong giao tiếp giữa người với người, cũng có thể là một yếu tố.

Bà Alexis Palmer, một nghiên cứu sinh tại Đại học Dartmouth, người đã nghiên cứu về khả năng tranh luận chính trị của LLM nhưng không tham gia vào nghiên cứu này, cho rằng: “Trong bối cảnh trò chuyện với ai đó về điều bạn không đồng ý, liệu có điều gì đó mang tính người bẩm sinh quan trọng đối với tương tác đó không? Hay là nếu một AI có thể bắt chước hoàn hảo lời nói đó, bạn sẽ nhận được kết quả hoàn toàn giống nhau?” Đây chính là “câu hỏi lớn bao trùm của AI” hiện nay.

Tia Sáng Hay Bóng Tối Bao Trùm? AI Trong Cuộc Chiến Chống Lại Tin Giả

Mặc dù thí nghiệm không hoàn toàn phản ánh cách con người tranh luận trực tuyến trong đời thực, nơi các yếu tố như ẩn danh, tương tác kéo dài và sự can thiệp của cộng đồng có thể thay đổi cục diện, nghiên cứu này vẫn cho thấy LLM có thể là một công cụ hiệu quả. Không chỉ để phổ biến, mà còn để chống lại các chiến dịch thông tin sai lệch hàng loạt.

Theo Tiến sĩ Gallotti, AI có thể được sử dụng để tạo ra “các câu chuyện phản biện được cá nhân hóa” nhằm giáo dục những người có thể dễ bị tổn thương trước sự lừa dối trong các cuộc trò chuyện trực tuyến. Ví dụ, một hệ thống AI có thể phân tích các dấu hiệu cho thấy một người đang tiếp xúc với tin giả và tự động cung cấp thông tin đính chính, được điều chỉnh cho phù hợp với trình độ hiểu biết và niềm tin hiện có của người đó.

Tuy nhiên, ông cũng nhấn mạnh rằng “cần khẩn trương có thêm nhiều nghiên cứu để khám phá các chiến lược hiệu quả nhằm giảm thiểu những mối đe dọa này.” Việc phát triển các công cụ chatbot có đạo đức, minh bạch và có khả năng giải thích được các quyết định của mình là vô cùng quan trọng.

Chúng ta biết rất nhiều về cách con người phản ứng với nhau, nhưng theo bà Palmer, hiểu biết về tâm lý học đằng sau cách con người tương tác với các mô hình AI vẫn còn rất hạn chế. Đây là một lĩnh vực cần được đầu tư nghiên cứu sâu rộng hơn nữa.

Kết luận

Sự thật rằng GPT-4 và các mô hình AI tương tự có khả năng tranh luận và thuyết phục vượt trội con người trong một số điều kiện nhất định là một bước tiến công nghệ đáng kể, nhưng cũng là một lời cảnh tỉnh mạnh mẽ. Khả năng AI thao túng dư luận là một nguy cơ hiện hữu, đòi hỏi sự chú ý và hành động ngay lập tức từ các nhà hoạch định chính sách, các công ty công nghệ và cả cộng đồng.

Việc xây dựng một hành lang pháp lý vững chắc, các tiêu chuẩn đạo đức rõ ràng và nâng cao nhận thức của công chúng về sức mạnh cũng như những rủi ro tiềm ẩn của AI là điều tối quan trọng. Tương lai của các cuộc tranh luận và dòng chảy thông tin đang đứng trước một bước ngoặt, và chúng ta cần trang bị cho mình những công cụ và hiểu biết cần thiết để định hình nó một cách có trách nhiệm.