Key Takeaways

- Nhiều hệ thống AI đang “học vẹt” dữ liệu thay vì thực sự học hỏi, dẫn đến đánh giá hiệu suất bị thổi phồng.

- Hiện tượng “ô nhiễm dữ liệu” xảy ra khi dữ liệu đánh giá bị lọt vào dữ liệu huấn luyện, làm sai lệch kết quả.

- Nghiên cứu cho thấy các Mô hình Ngôn ngữ Lớn (LLM) có kiến thức sâu rộng về bộ dữ liệu MovieLens-1M, thậm chí có thể khôi phục phần lớn thông tin từ nó.

- Việc ghi nhớ dữ liệu có thể dẫn đến hiệu suất “ảo” và sự thiên vị, khi mô hình ưu tiên những thông tin phổ biến đã được ghi nhớ.

- Cần có các phương pháp đánh giá AI mới để đảm bảo tính khách quan và tránh những kết quả sai lệch do học thuộc lòng.

Bạn có tin tưởng tuyệt đối vào những gợi ý phim ảnh, sách truyện hay sản phẩm mà AI đưa ra? Một nghiên cứu mới đây đã gióng lên hồi chuông cảnh báo: không ít hệ thống AI đang “trả bài” dựa trên trí nhớ thay vì năng lực thực sự. Thay vì học hỏi để đưa ra đề xuất hữu ích, các mô hình này thường xuyên “học vẹt” các mục trong bộ dữ liệu dùng để đánh giá chúng, dẫn đến hiệu suất bị thổi phồng và những gợi ý có thể lỗi thời hoặc không phù hợp với người dùng.

Vấn đề “Học Vẹt” Của AI: Khi Trí Nhớ Đánh Lừa Kỹ Năng

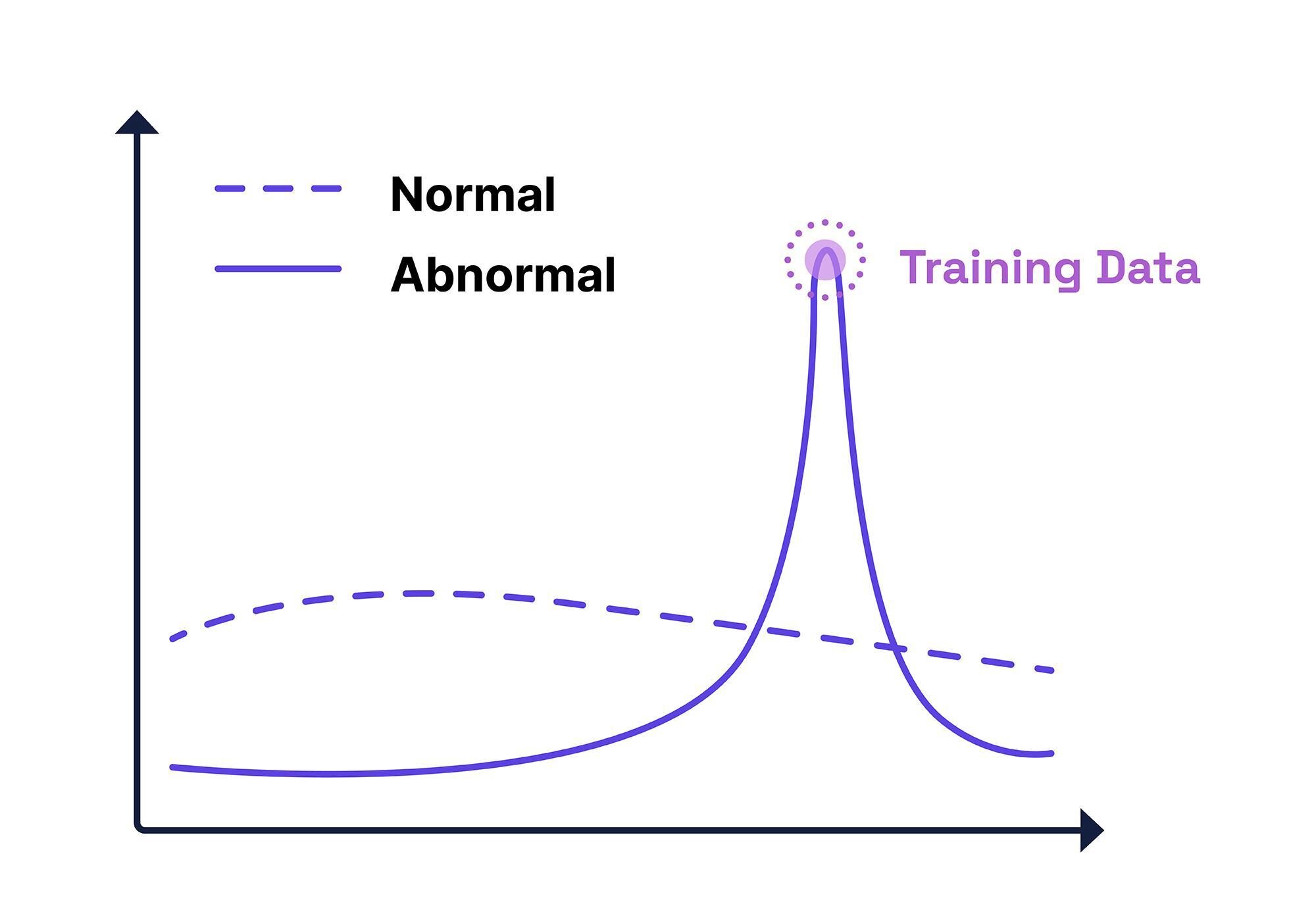

Trong lĩnh vực học máy, việc phân chia dữ liệu thử nghiệm (test-split) là một bước tối quan trọng. Nó giúp đánh giá xem một mô hình đã được huấn luyện có khả năng giải quyết các vấn đề tương tự, nhưng không hoàn toàn giống hệt, với dữ liệu huấn luyện hay không.

Hãy tưởng tượng một mô hình AI mới nhận dạng giống chó được huấn luyện trên 100.000 bức ảnh. Thông thường, dữ liệu sẽ được chia theo tỷ lệ 80/20: 80.000 ảnh dùng để huấn luyện và 20.000 ảnh được giữ lại để kiểm tra mô hình sau khi hoàn thiện. Rõ ràng, nếu dữ liệu huấn luyện vô tình chứa cả 20% “bí mật” này, mô hình sẽ dễ dàng “qua mặt” bài kiểm tra vì nó đã “biết trước” đáp án. Điều này không phản ánh chính xác hiệu suất của mô hình khi đối mặt với dữ liệu mới trong thực tế.

“Gian Lận” Quy Mô Lớn: Hiện Tượng Ô Nhiễm Dữ Liệu

Vấn nạn AI “gian lận thi cử” ngày càng trở nên nghiêm trọng hơn cùng với sự gia tăng quy mô của chính các mô hình. Các hệ thống ngày nay được huấn luyện trên những kho dữ liệu khổng lồ, được thu thập một cách không chọn lọc từ web, ví dụ như Common Crawl. Do đó, khả năng các bộ dữ liệu đánh giá (benchmark datasets) – tức 20% dữ liệu thử nghiệm – bị “lọt” vào kho dữ liệu huấn luyện không còn là trường hợp cá biệt nữa, mà đã trở thành một hội chứng được gọi là ô nhiễm dữ liệu (data contamination). Ở quy mô này, việc sàng lọc thủ công để phát hiện lỗi là bất khả thi về mặt hậu cần.

Nghiên Cứu “Vạch Trần”: MovieLens-1M Và Những Tiết Lộ Gây Sốc

Một nghiên cứu mới từ Politecnico di Bari (Ý) đã đào sâu vào vấn đề này, đặc biệt tập trung vào vai trò quá lớn của một bộ dữ liệu đề xuất phim ảnh duy nhất: MovieLens-1M. Các nhà nghiên cứu cho rằng bộ dữ liệu này đã bị một số mô hình AI hàng đầu “học thuộc lòng” một phần trong quá trình huấn luyện.

Do MovieLens-1M được sử dụng quá phổ biến trong việc kiểm tra các hệ thống đề xuất, sự hiện diện của nó trong “trí nhớ” của mô hình có khả năng làm cho các bài kiểm tra trở nên vô nghĩa. Những gì tưởng chừng là trí thông minh thực chất chỉ là khả năng nhớ lại đơn thuần, và kỹ năng đề xuất trực quan có vẻ chỉ là một tiếng vọng thống kê từ việc tiếp xúc trước đó.

Các tác giả khẳng định: “Phát hiện của chúng tôi cho thấy các Mô hình Ngôn ngữ Lớn (LLM) sở hữu kiến thức sâu rộng về bộ dữ liệu MovieLens-1M, bao gồm các mục, thuộc tính người dùng và lịch sử tương tác. Đáng chú ý, một câu lệnh đơn giản cho phép GPT-4o khôi phục gần 80% [tên của hầu hết các bộ phim trong bộ dữ liệu].”

Họ cũng nhấn mạnh: “Không có mô hình nào được kiểm tra thoát khỏi kiến thức này, cho thấy dữ liệu MovieLens-1M có khả năng đã được đưa vào bộ huấn luyện của chúng. Chúng tôi quan sát thấy xu hướng tương tự trong việc truy xuất thuộc tính người dùng và lịch sử tương tác.” Nghiên cứu ngắn gọn này có tiêu đề “Do LLMs Memorize Recommendation Datasets? A Preliminary Study on MovieLens-1M” (Liệu LLM có ghi nhớ các bộ dữ liệu đề xuất không? Một nghiên cứu sơ bộ về MovieLens-1M).

Phương Pháp Kiểm Tra Và Kết Quả Thực Tế

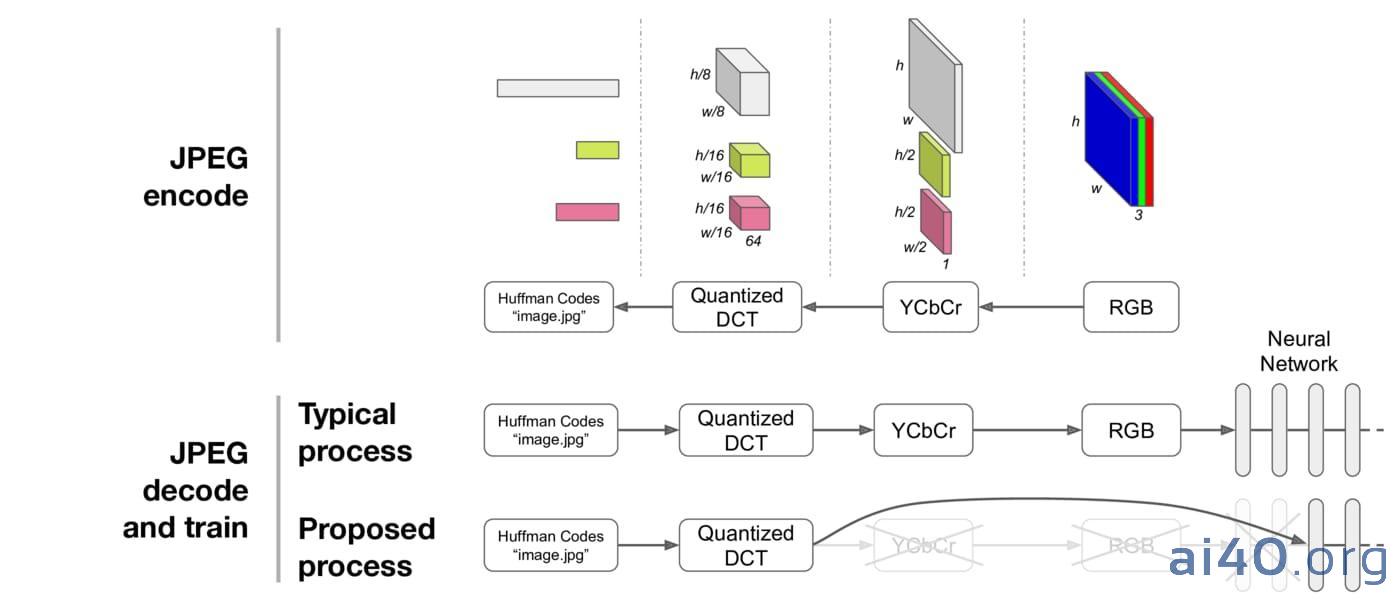

Để làm rõ liệu các mô hình đang thực sự học hỏi hay chỉ đơn thuần nhớ lại, các nhà nghiên cứu đã bắt đầu bằng cách định nghĩa “ghi nhớ” trong bối cảnh này. Họ kiểm tra khả năng của mô hình trong việc truy xuất các mẩu thông tin cụ thể từ bộ dữ liệu MovieLens-1M khi được gợi ý đúng cách.

Cách AI “Trả Bài”

Việc một mô hình có thể đưa ra tên và thể loại phim từ mã ID của nó được coi là ghi nhớ mục (item memorization). Nếu nó có thể tạo ra chi tiết về người dùng (như tuổi, nghề nghiệp, mã zip) từ ID người dùng, đó là ghi nhớ người dùng (user memorization). Và nếu nó có thể tái tạo lại đánh giá phim tiếp theo của người dùng từ một chuỗi các đánh giá trước đó đã biết, đây được xem là bằng chứng cho thấy mô hình có thể đang nhớ lại dữ liệu tương tác (interaction data) cụ thể, thay vì học các mẫu chung.

Các bài kiểm tra này sử dụng các câu lệnh (prompt) được soạn thảo cẩn thận, nhằm “gợi ý” mô hình mà không cung cấp thông tin mới. Phản hồi càng chính xác, khả năng mô hình đã gặp dữ liệu đó trong quá trình huấn luyện càng cao.

Dữ Liệu Và Các “Thí Sinh” Tham Gia

Bộ dữ liệu MovieLens-1M bao gồm ba tệp chính: Movies.dat (phim theo ID, tên, thể loại), Users.dat (thông tin người dùng), và Ratings.dat (ai đã đánh giá gì, khi nào). Để xem liệu dữ liệu này có bị LLM “học thuộc” hay không, các nhà nghiên cứu đã sử dụng kỹ thuật đặt câu hỏi trực tiếp mô phỏng định dạng của bộ dữ liệu.

Các mô hình được đưa vào “thử thách” bao gồm: GPT-4o, GPT-4o mini, GPT-3.5 turbo, Llama-3.3 70B, Llama-3.2 3B, Llama-3.2 1B, Llama-3.1 405B, Llama-3.1 70B, và Llama-3.1 8B.

Kết quả ban đầu cho thấy sự khác biệt rõ rệt không chỉ giữa gia đình GPT và Llama mà còn giữa các kích thước mô hình. Trong khi GPT-4o và GPT-3.5 turbo dễ dàng khôi phục phần lớn bộ dữ liệu, hầu hết các mô hình mã nguồn mở chỉ nhớ được một phần nhỏ. Đáng kinh ngạc, GPT-4o cho thấy tỷ lệ bao phủ đủ cao để cho thấy một phần không nhỏ của bộ dữ liệu đã được ghi nhớ trực tiếp.

Hệ Lụy Của Việc “Học Tủ”: Đánh Giá Sai Lệch Và Thiên Vị

Tiếp theo, các nhà nghiên cứu đã kiểm tra tác động của việc ghi nhớ đối với các tác vụ đề xuất. Kết quả cho thấy một số LLM vượt trội hơn so với các phương pháp truyền thống, với GPT-4o dẫn đầu một cách đáng kể.

Hiệu Suất “Ảo” Từ Việc Ghi Nhớ

Các tác giả chỉ ra một quy luật thú vị: “Trong mỗi nhóm, mô hình có khả năng ghi nhớ cao hơn cũng thể hiện hiệu suất vượt trội hơn trong tác vụ đề xuất.” Ví dụ, GPT-4o vượt trội hơn GPT-4o mini, và Llama-3.1 405B vượt qua Llama-3.1 70B và 8B.

“Những kết quả này nhấn mạnh rằng việc đánh giá LLM trên các bộ dữ liệu đã bị rò rỉ trong dữ liệu huấn luyện của chúng có thể dẫn đến hiệu suất quá lạc quan, được thúc đẩy bởi sự ghi nhớ chứ không phải khả năng khái quát hóa,” nghiên cứu kết luận.

Quy Mô Mô Hình Và Xu Hướng “Nhớ Dai”

Có một mối tương quan rõ ràng giữa kích thước mô hình, khả năng ghi nhớ và hiệu suất đề xuất. Các mô hình lớn hơn không chỉ lưu giữ nhiều hơn dữ liệu MovieLens-1M mà còn hoạt động mạnh mẽ hơn. Ví dụ, Llama-3.1 405B có tỷ lệ ghi nhớ trung bình là 12.9%, trong khi Llama-3.1 8B chỉ giữ lại 5.82%. Sự sụt giảm gần 55% này trong khả năng nhớ lại tương ứng với mức giảm 54.23% về chỉ số nDCG và 47.36% về HR.

Điều này cho thấy việc tăng quy mô mô hình dẫn đến khả năng ghi nhớ bộ dữ liệu lớn hơn, từ đó cải thiện hiệu suất. Tuy nhiên, nó cũng gây ra rủi ro liên quan đến việc rò rỉ dữ liệu huấn luyện tiềm ẩn.

Thiên Vị Phổ Biến: Ưu Ái Những Gì Quen Thuộc

Bài kiểm tra cuối cùng xem xét liệu việc ghi nhớ có phản ánh sự thiên vị về mức độ phổ biến đã có sẵn trong MovieLens-1M hay không. Kết quả cho thấy các mô hình lớn hơn liên tục ưu tiên các mục phổ biến nhất. GPT-4o truy xuất được 89.06% các mục được xếp hạng cao nhất nhưng chỉ 63.97% các mục ít phổ biến nhất.

“Phát hiện của chúng tôi cho thấy một sự thiên vị phổ biến rõ rệt trong các LLM, với 20% các mục phổ biến nhất dễ truy xuất hơn đáng kể so với 20% các mục cuối cùng,” các nhà nghiên cứu cho biết. Xu hướng này nhấn mạnh ảnh hưởng của sự phân bổ dữ liệu huấn luyện, nơi các bộ phim nổi tiếng được đại diện quá mức, dẫn đến việc chúng bị các mô hình ghi nhớ một cách không cân xứng.

Kết luận

Tình thế tiến thoái lưỡng nan này không còn mới: khi bộ dữ liệu huấn luyện ngày càng phình to, khả năng sàng lọc chúng lại giảm đi theo tỷ lệ nghịch. MovieLens-1M, và có lẽ nhiều bộ dữ liệu khác, đã âm thầm xâm nhập vào các kho dữ liệu khổng lồ này mà không có sự giám sát, ẩn mình giữa vô vàn thông tin. Vấn đề này lặp lại ở mọi quy mô và chống lại sự tự động hóa. Bất kỳ giải pháp nào cũng đòi hỏi không chỉ nỗ lực mà còn cả sự phán đoán của con người – loại phán đoán chậm chạp, dễ sai sót mà máy móc không thể cung cấp. Về mặt này, nghiên cứu mới dù vạch trần thực trạng đáng lo ngại nhưng chưa đưa ra được một lối thoát triệt để. Việc đánh giá AI cần có những phương pháp mới để đảm bảo tính khách quan và tránh những kết quả “ảo” do mô hình học thuộc lòng.